1.彩票预测参考:https://www.7forz.com/3319/https://www.cnblogs.com/wenzb/p/10899313.html2.家谱首页:X氏家谱 (起源)定位个人信息:大头贴头像出生:[出生时间、出生地] 现状:[去世时间、埋...

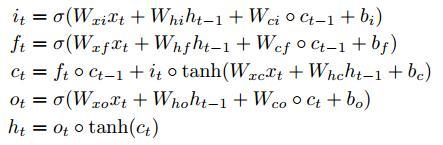

LSTM变体FC-LSTM:对应更新公式为:其中,空心小圆圈表示矩阵对应元素相乘,又称为Hadamard乘积。ConvLSTM结构与FC-LSTM类似,不过将矩阵乘操作,换成了卷积操作。更新公式如下: 其中,it,ft...

损失函数NLLLoss() 的输入是一个对数概率向量和一个目标标签.它不会为我们计算对数概率,适合最后一层是log_softmax()的网络. 损失函数CrossEntropyLoss()与NLLLoss()类似,唯一的不同是它为我们去做log_softmax....

RNN、LSTM、GRU的结构与PyTorch调用方式基本一致,此处以RNN为例进行说明。pytorch中的RNN,torch.nn.RNN():参数: 参数含义注意input_size输入x的特征维度数量是特征维度,不是序列长度hidden_size隐状态...

LSTM是一种特殊的RNN,其引入状态量来保留历史信息,同时引入门的概念来更新状态量。RNN:LSTM:原理RNN网络中历史信息在每个RNN单元,都经过tanh/ReLu,信息在逐渐流失;而LSTM,采用信息更新的方式,更容易将有用的信息传递下去,传得更远。也就是下图中C随序列传递的过程。为了实现状...

RNN(RecurrentNeuralNetwork)是一类用于处理序列数据的神经网络,最常见的是时间序列、文字序列。基础神经网络(常规CNN)与RNN 我们从基础的神经网络中知道,神经网络包含输入层、隐层、输出层,通过激活函数控制输出,层与...

https://blog.csdn.net/gzj_1101/article/details/79376798https://www.jianshu.com/p/95d5c461924c...

源于:https://www.cnblogs.com/hf19950918/p/10671413.html物体在快速运动时,当人眼所看到的影像消失后,人眼仍能继续保留其影像,约0.1-0.4秒左右的图像,这种现象被称为视觉暂留现象。人类在观看视频时,利用视觉暂留机制和记忆能力,可以快速处理视频流。借...

【2019.11.13-1】 问题:RuntimeError:CUDAERROR:anillegalmemoryaccesswasencountered 定位解决:groundtruth中有类别超了,计算loss时需要添加ignore_index来忽略对应类...

- 搜索

- 控制面板

- 最近发表

- 最新留言

;

filter:progid:DXImageTransform.Microsoft.AlphaImageLoader(src='https://img-blog.csdnimg.cn/20190613125429853.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3poYW9qYzE5OTU=,size_16,color_FFFFFF,t_70)

;)